☄️ Ya no mires atrás - Resumen Resumido #151

Esta semana estuvo llena de noticias de IA marcadas por el impacto de DeepSeek-R1 en los mercados y los medios. Te resumo todo aquí.

⏱️ El Resumen Resumido de hoy se lee en tan sólo 9 minutos

Únete a los más de 1.500 lectores que se mantienen actualizados semanalmente con el Resumen Resumido, y recibe lo último de Tecnología e Inteligencia Artificial para potenciar tu marca y negocio.

Uff que semana más intensa. Brutal cierre de un enero que se sintió eterno, pero con aprendizajes increíbles y una mejor definición de qué es lo que quiero hacer este 2025.

Por mi parte terminé de dictar mi curso intensivo de IA para alumnos de negocios en DUOC, donde aproveché de utilizar distintas IA para optimizar la creación de materiales educativos, entre otras cosas, que están quedando muy bien.

También, comencé la primera versión de mi curso abierto de IA para el resto de nosotros con cerca de 30 participantes, y me ha gustado mucho (aunque ya tengo algunos aprendizajes para ajustar para la siguiente versión que se viene en la segunda mitad de febrero, si te interesa estar al tanto de estos cursos puedes unirte a mi grupo de WhatsApp donde iré compartiendo toda la información)

Por otra parte participé de dos webinars, uno sobre Ley de Protección de Datos Personales e Inteligencia Artificial organizado por LeyDeDatos.com, donde conversamos junto a Ivonne Bueno sobre los desafíos que se vienen en estos temas.

Y el otro, donde compartí sobre cómo usar la IA como super poder en nuestro día a día organizado por Le Wagon. (No encontré el vídeo de este).

Pero lo más importante fue que por pedido del público cree el grupo de Memes de IA en mi comunidad de WhatsApp, así que si quieres unirte te dejo el enlace acá:

Pero bueno, mucho blablá, es hora de ir a una edición INTENSA del Resumen Resumido. ¡Vamos allá!

🤖 El Rincón de la IA

Ponte al día con las últimas noticias de Inteligencia Artificial

🐳 DeepSeek: la ballena en la habitación

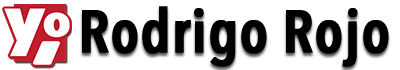

Esta semana vimos como la llegada del modelo de "razonamiento" de DeepSeek que salió la semana pasada, bautizado como DeepSeek-R1, empezó a causar un estrago mediático de proporciones, así que acá quiero contarte un poco de dónde viene tanto revuelo, y por qué hay que mirar lo que está pasando con esta empresa china.

Voy a tratar de resumirlo lo más posible DeepSeek-R1 es una versión "con razonamiento" de DeepSeek-V3, un LLM creado por un laboratorio chino (primer punto de la discordia) y que, a nivel de calidad, está a un nivel muy similar a los modelos SOTA (estado del arte): GPT-4o, Claude Sonnet New 3.5, Gemini 2.0 Flash, y similares.

La "magia" de DeepSeek-R1

Pero la gracia de DeepSeek con su versión R1, tiene 3 partes muy interesantes:

- Viene con el modo "razonar antes de contestar" inspirado en lo que hizo OpenAI con o1, con la diferencia de que en vez de darte un "resumen de lo que pensó", te entrega la cadena de pensamiento completa, y lo lanzó gratis a través de su aplicación (con servidores en China)

- Es de código abierto, así que cualquiera lo puede descargar e instalar en un servidor o computador propio (ojo: dependiendo de la capacidad del computador vas a elegir una versión más o menos poderosa)

- Pero aún más importante: en el whitepaper donde cuentan como lo hicieron, revelaron que crearon varias técnicas nuevas y optimizaciones para poder crearlo a una fracción del costo $6M de USD, en comparación con los cientos de millones que los laboratorios como OpenAI, Meta AI o Anthropic gastaron en sus modelos.

Si te interesa el detalle de cómo construyeron R1, este post ilustra muy bien las diferentes técnicas que usaron.

El golpe mediático...y al ego

Esto hizo que se viralizara muy rápido, y que rápidamente se descubriera que habían ciertas cosas que DeepSeek no podía contestar (como por ejemplo lo que pasó en la plaza de Tienmen en 1989).

Los laboratorios de IA de occidente están súper golpeados, porque estaban acostumbrados a que eran ellos quienes avanzaban los niveles de desarrollo, y ahora tenemos a Meta armando un cuarto de guerra para entender qué hizo DeepSeek, a Microsoft y OpenAI alegando que DeepSeek entrenó el modelo con outputs de ChatGPT (lo que va en contra de los términos y condiciones), y a varios analistas diciendo lo importante que es que "Estados Unidos y sus aliados sean lo que logren la ventaja en la era de la IA por sobre el régimen comunista de China".

(Si quieres saber más sobre el tema geopolítico, este post de Dario Amodei, CEO de Anthropic, habla muy en detalle acerca de esto)

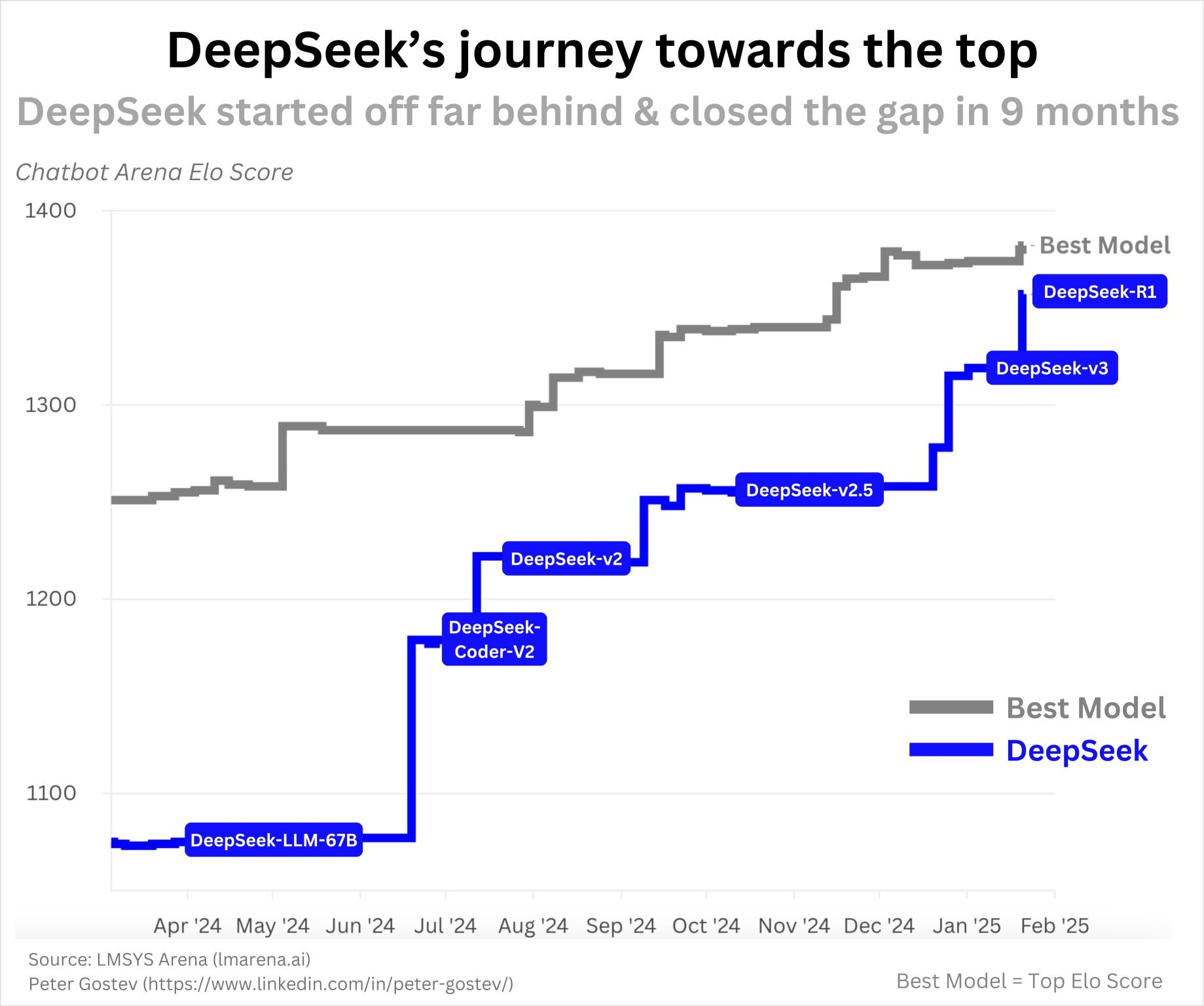

Pero el golpe más duro, fue que las acciones de NVIDIA que no habían parado de subir en estos últimos años tuvieran la mayor caída en un solo día en bolsa jamás vista, debido a que "con las técnicas nuevas de DeepSeek" ya no sería tan necesario tener chips tan poderosos (aunque los expertos dicen que esto fue más una sobrereacción, que una realidad).

Lo bueno es que al ser de código abierto, todos pueden tratar de adaptar las nuevas técnicas, o basarse en DeepSeek-R1 para crear nuevas versiones y ajustes. No por nada el modelo ya está disponible para su uso a través de AWS, Azure de Microsoft, y en aplicaciones para el consumidor final como Perplexity.

Aunque esto no se quedará acá, ya que la misma semana DeepSeek sacó otro modelo, Janus-Pro que es una versión multimodal que incluye la creación de imágenes y más. Esto ya no se detiene.

Para mí fuera de todo el caos geopolítico, y los golpes en la bolsa, esto se trata de un punto de inflexión en el avance de la IA que muy bien describe Andrej Karpathy (uno de los miembros fundadores de OpenAI) en el tweet que te dejo más abajo: estamos empezando a ver cómo los nuevos modelos de IA empiezan a demostrar, mediante prueba y error, una especie de "monólogo humano de pensamiento" donde el modelo para tratar de resolver el problema, empieza a ponerse creativo de una forma a la que no fue programado. A crear nuevas formas de resolver problemas. Y eso es increíble, y abre las posibilidades a encontrar soluciones a problemas que los humanos solos no hemos logrado.

(aunque también es algo creepy)

"Move 37" is the word-of-day - it's when an AI, trained via the trial-and-error process of reinforcement learning, discovers actions that are new, surprising, and secretly brilliant even to expert humans. It is a magical, just slightly unnerving, emergent phenomenon only…

— Andrej Karpathy (@karpathy) January 28, 2025

🚀 O3-mini: OpenAI no se queda de brazos cruzados

Pero la cosa no para, porque a final de la semana OpenAI lanzó o3-mini una familia de modelos de pensamiento que construye sobre lo que habían hecho con o1 y lo lleva al siguiente nivel. Lo lanzaron tanto en la aplicación como en la API, y tiraron toda la carne a la parrilla. La gracia es que es el primer modelo de "razonamiento" que soporta búsqueda web (para aumentar su respuesta con información actualizada) function calling (poder interactuar con herramientas), y outputs estructurados (para pedirle que entregue las cosas en cierto formato específico para aplicaciones.

Está disponible en cuentas Plus ($20 usd), Team ($25 usd) y Pro ($200 USD), reemplazando a o1-mini, y con mayor límite de mensajes diarios (de los 50 en o1-mini a 150!).

Está súper interesante y según las primeras pruebas que he hecho y he visto, está a un nivel bastante superior en diversas tareas. Si tienes la cuenta de pago te invito a probarlo!

📝 Mi opinión personal: da lo mismo el modelo

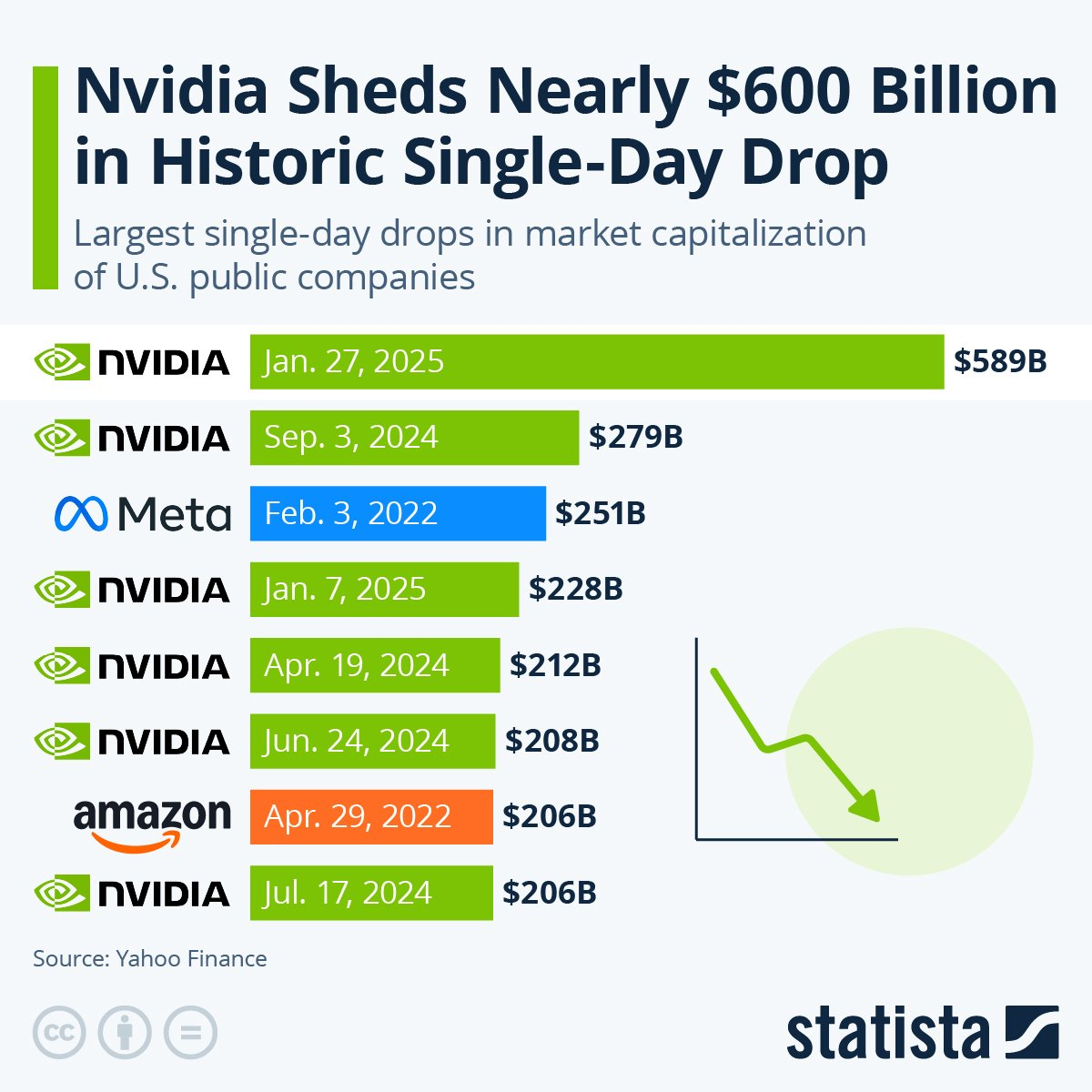

Desde el lanzamiento de Llama 3 de Meta que llegamos con los distintos modelos -ya sean de código abierto o de código cerrado- a un nivel de calidad suficientemente bueno para la gran mayoría de los mortales. Una especie de "convergencia" de sus capacidades.

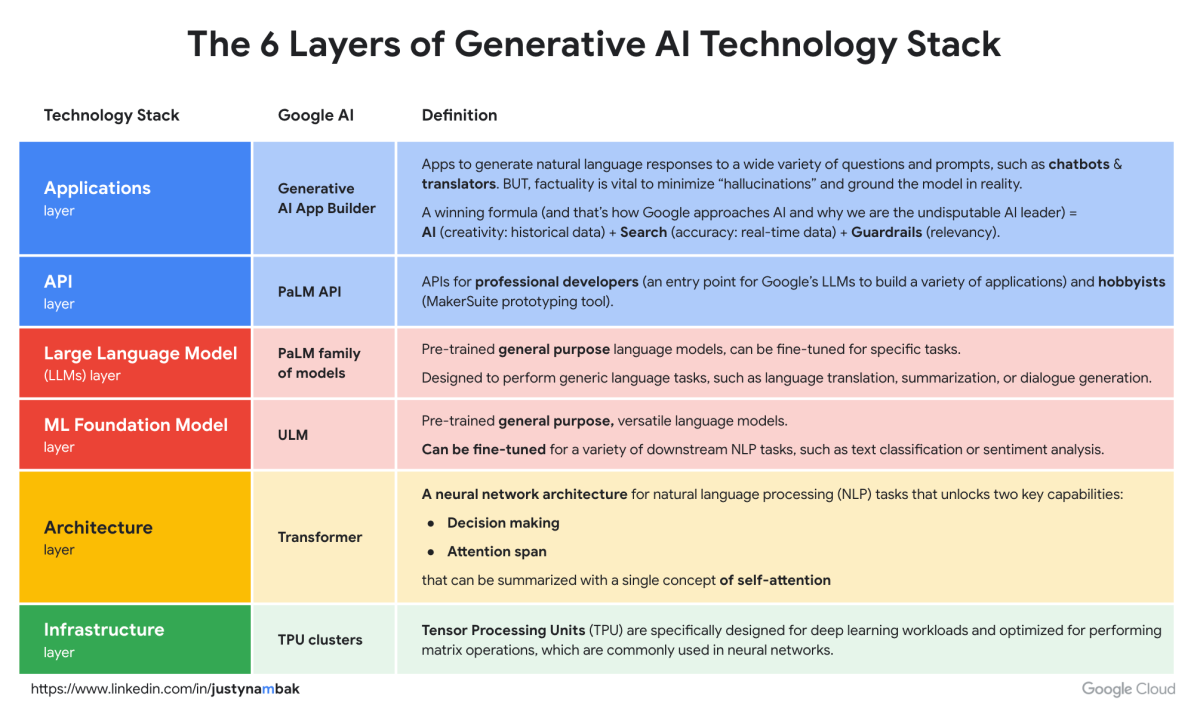

A estas alturas, al menos a mi parecer, el modelo detrás de lo que uses da un poco lo mismo (aunque hay modelos ligeramente mejores en ciertas tareas que otros), sino que lo que importa realmente es lo que sucede "en la capa de aplicaciones" que es donde el común de los mortales como nosotros va a estar trabajando.

Son las aplicaciones generales como ChatGPT, Claude o Gemini, y las aplicaciones especialistas (como Midjourney, Suno, Copilot 365, etc) donde las funciones de IA permiten acelerar al usuario en la resolución de tareas y darle verdaderos poderes.

El modelo que hay debajo da lo mismo, siempre será "el mejor disponible". Lo que importa es que te permita hacer más, mejor y en menos tiempo.

En particular veo a las apps especialistas como las grandes ganadoras, porque es ahí donde se necesita que resuelvan mejor las cosas. Por ejemplo: funciones de edición de imágenes con IA directo en Photoshop, o aplicaciones de redacción de documentos como Word o Notion, que puedan acelerar el trabajo del documento desde información no estructurada o de otros archivos.

Son esas cosas las que le importan realmente "al humano de a pie" así que no hay que desesperarse porque las cosas estén pasando muy rápido, hay que invertir el tiempo en buscar esas aplicaciones que solucionan tus problemas diarios y te ayudan a ganar velocidad.

Si quieres probar distintas herramientas de IA para tu día a día, he compilado una colección con las aplicaciones de IA que más me gustan, que puedes encontrar acá.

Y también he compilado todas mis charlas y cursos gratuitos acá por si quieres partir descubriendo este mundo.

Otras noticias

- Alibaba lanza Qwen 2.5 Max, su modelo de "Mix de Expertos" (MoE) que en los distintos benchmarks se ubica al mismo nivel que los modelos top.

- Microsoft agrega el agente "Project Manager" a Planner en su suite de Microsoft 365. Por lo que ahora el agente puede subdividir tareas por ti.

- Mistral AI, el laboratorio de IA basado en Francia, lanza Small 3, su modelo más pequeño y versátil

- Krea agrega AI Chat en su herramienta creativa, permitiendo ahora poder interactuar con los distintos modelos de creación de imagen y video en su suite desde una interfaz de chat.

- Pika lanza la versión 2.1 AI Video, incorporando resolución 1080p, la posibilidad de tener personajes consistentes, y mucho más.

- Kimi lanza su propio modelo con "razonamiento" uniéndose a la nueva tendencia.

- Google lanza AI Weather Forecast, mediante la cual agrupó todos sus avanzados modelos meteorológicos en una misma familia. Se trata de los modelos de predicción atmosférica más avanzados a la fecha.

💊 La píldora

Todas las semanas te traigo una píldora para abrir la mente y salir de la Matrix.

La gente de MyMind se saca unas frases notables, y esta última que compartieron me hizo todo el sentido del mundo: tienes que estar para ti mismo!! Apóyate, anímate, y empújate a ser la mejor versión de ti mismo.

Las cosas solo crecerán desde ahí.

💡 Datos Random

Descubrimientos entretenidos de mi semana

Apps para Mac en 2025

Hace poco cambié mi Macbook Pro M1 por uno con chip M4 y el salto es brutal, así que decidí configurarlo desde cero y empezar a probar aplicaciones que me puedan servir para acelerar el día a día. Este vídeo de ByteReview comparte varias gemas.

También te dejo este vídeo del gran iSenaCode sobre apps para Mac que quizás no conocías.

Consejos y tips para el iPad M4

Mi dispositivo favorito es mi iPad, y Christopher Lawley como siempre, comparte tremendos tips para sacarle el máximo provecho en este vídeo.

El Manual de Monstruos 2024 de D&D cada vez está más cerca

Ya falta muy poco para empezar a jugar con los nuevos monstruos de la edición revisada de Dungeons&Dragons, y como normalmente juego de Dungeon Master, es el libro que más estoy esperando. En este vídeo PointyHat nos comenta sobre todos los monstruos.

Construye Agentes de IA

Este vídeo para crear mini-agentes de IA usando N8N está súper bueno!.

🛠️ Herramientas Recomendadas

¡Nuevas herramientas todas las semanas!

- 💧 Raindrop: es una aplicación que te permite tener todos tus favoritos/bookmarks en un mismo lugar independiente del navegador que estás usando. Ideal si usas múltiples dispositivos o navegadores.

- 📊 Meridian: Google lanzó su herramienta de Marketing Mix Modeling de código abierto para que las marcas y agencias puedan optimizar sus presupuestos de marketing.

- 🐳 DeepClaude: es una API unificada de código abierto y gratuita a la cuál conectas tus apis de DeepSeek y de Claude, y permite usar el modelo de razonamiento del primero como orquestrador de tareas, y el poder de Claude para resolverlas. Si desarrollas código, este combo se ve súper bueno.

👋 Palabras al Cierre

¡Y hasta aquí llegó esta edición! Si te gusta lo que hago y quieres ayudar a que el Resumen Resumido ™ siga creciendo, puedes apoyarme por el precio de un café mensual, y podrás ser parte de la Patrulla Roja, mi comunidad exclusiva de WhatsApp, además de otros beneficios adicionales como descuentos y mucho más.

Cualquier comentario o consulta escríbeme en LinkedIn, o en Twitter a @rodrigorojop, me hace muy feliz recibir tu feedback.