GPT-5.3 Codex: El Modelo que Ayudó a Construirse a Sí Mismo

GPT-5.3-Codex de OpenAI "se construyó a sí mismo". ¿Qué significa realmente? Benchmarks, nueva app macOS y por qué Codex ya no es solo un modelo de código.

OpenAI lanzó GPT-5.3-Codex, y el titular que está circulando es irresistible:

“El modelo que se construyó a sí mismo.”

Spoiler: no es exactamente así. Pero la realidad es igual de interesante.

🤖 ¿Qué significa “se construyó a sí mismo”?

OpenAI dice que GPT-5.3-Codex fue “instrumental en su propia creación”.

¿Qué hizo el modelo durante su desarrollo?

- Gestionó deployments

- Debugging de su propio código

- Manejó resultados de tests y evaluaciones

Es decir: el equipo de OpenAI usó Codex para desarrollar… Codex.

No es que el modelo “se entrenó solo” (eso sería otra cosa). Pero sí participó activamente en las tareas de desarrollo que normalmente hacen los ingenieros.

Y eso dice mucho de hacia dónde va esto.

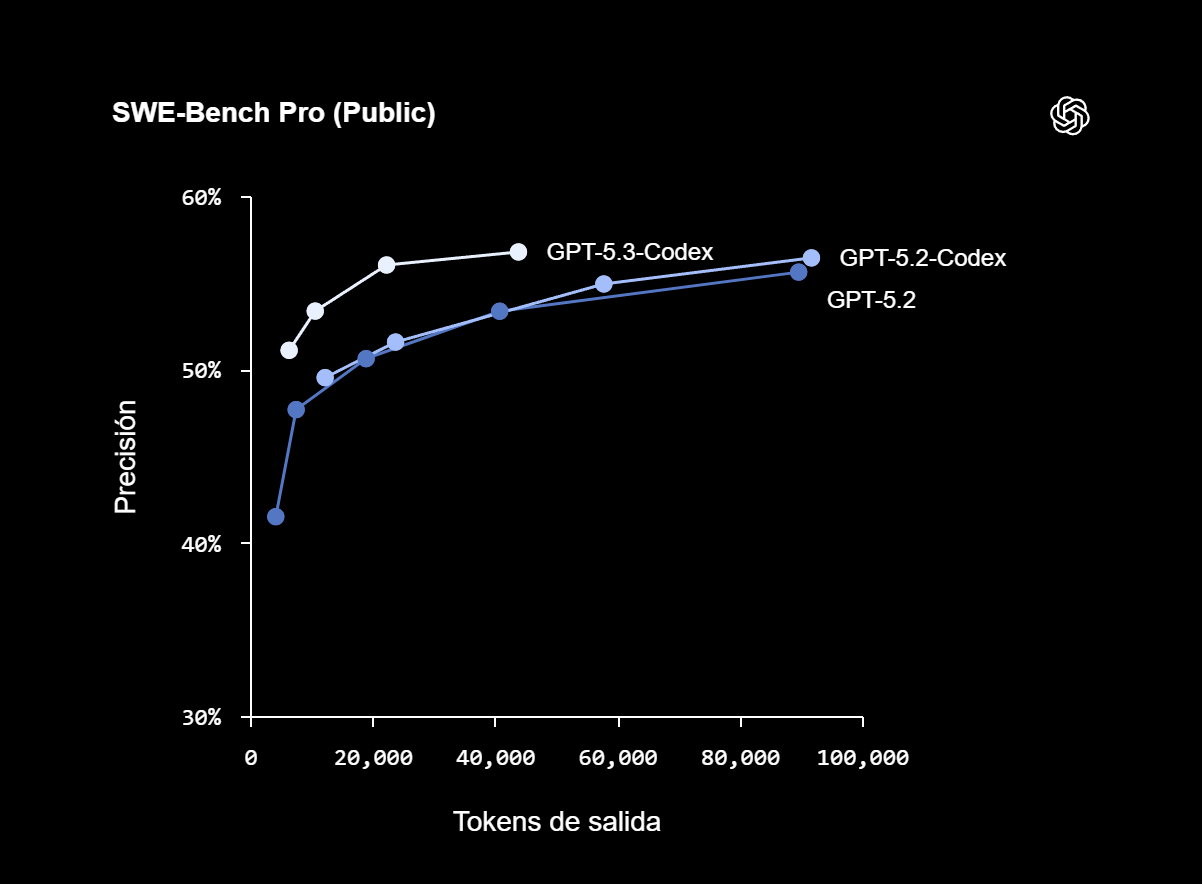

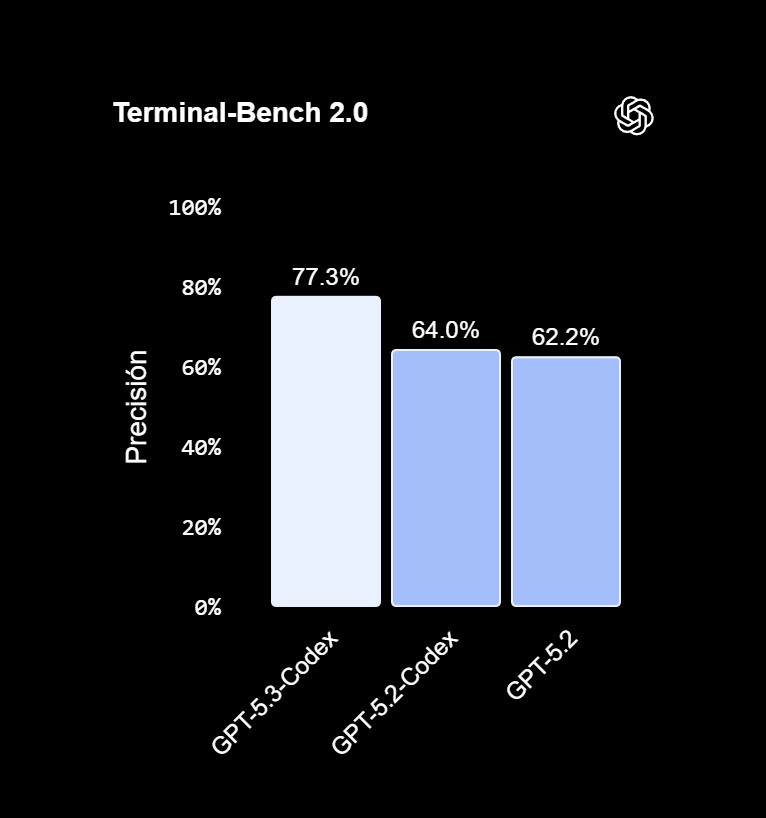

🚀 Los números

| Métrica | Resultado |

|---|---|

| Velocidad | 25% más rápido que GPT-5.2-Codex |

| SWE-Bench Pro | Nuevo récord |

| Terminal-Bench 2.0 | Nuevo récord |

Para los que no siguen los benchmarks: SWE-Bench es el estándar para medir qué tan bien un modelo puede resolver issues reales de GitHub. Terminal-Bench mide tareas en la línea de comandos.

Que Codex lidere ambos es una declaración de intenciones.

📱 Dónde está disponible

OpenAI lanzó GPT-5.3-Codex en todas partes al mismo tiempo:

- CLI (línea de comandos)

- Extensión de IDE (VS Code, etc.)

- Interfaz web de ChatGPT

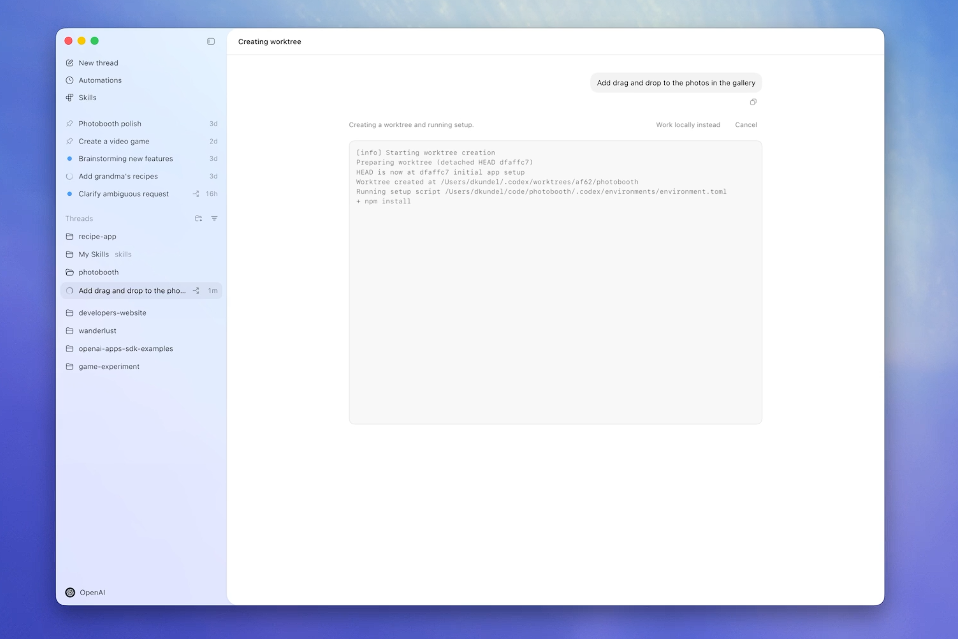

- Nueva app de macOS (esto es nuevo)

API viene próximamente.

Lo interesante es que ya no es solo “un modelo de código”. OpenAI lo posiciona para todo el ciclo de vida del software:

- Debugging

- Deploys

- Monitoring

- Escribir PRDs

- Editar copy

- User research

- Tests

- Métricas

Básicamente, todo lo que hace un equipo de producto… lo puede hacer Codex.

💡 El cambio de enfoque

La frase clave del anuncio:

“Codex no es solo para generar código. Es para todo el trabajo del ciclo de software.”

Esto me recuerda a lo que Anthropic anunció con Claude Opus 4.6 y el concepto de “vibe working”.

Ambas empresas están diciendo lo mismo: la IA ya no es un asistente para una tarea. Es un agente para flujos de trabajo completos.

Steering mid-task

Un detalle que me llamó la atención: ahora puedes redirigir a Codex mientras trabaja.

Antes el flujo era:

- Das un prompt

- Esperas

- Recibes el resultado

- Corriges y repites

Ahora es:

- Das un prompt

- Codex empieza a trabajar

- Le pides cambios y ajustes en el camino si ves que va mal

- Resultado más afinado

Parece menor, pero reduce mucho la frustración de “esperar 2 minutos para darte cuenta que no era lo que querías”.

🧭 Mi perspectiva

Uso Codex bastante es parte del stack que tengo configurado con OpenClaw para tareas de código.

Lo que veo con 5.3:

- Más rápido = menos fricción para tareas pequeñas

- Más allá del código = útil para PMs, no solo devs

- App macOS = OpenAI tomándose en serio el escritorio

¿Es razón para suscribirse a ChatGPT Pro? Si ya lo tienes, esto viene incluido. Si no, depende de cuánto código escribes.

Pero la tendencia es clara: los modelos de código se están convirtiendo en modelos de “trabajo de software”. Y eso incluye mucho más que escribir funciones.

🔗 Links

¿Usas Codex o Claude Code? ¿Cuál prefieres? Me interesa saber tu experiencia 👇